Tour d’horizon des principales tentatives de prédictions électorales revendiquant l’usage d’une intelligence artificielle aux Etats-Unis, mais aussi en France…

Les algorithmes d’intelligence artificielle font régulièrement la une pour leurs prouesses ou leurs capacités prédictives. Elles anticipent des catastrophes naturelles, des cancers ou des accidents cardiovasculaires, battent des champions d’échecs ou du jeu de go, établissent des pronostics sportifs, ou anticipent même les héros qui vont mourir dans Game of Thrones…. Mais peuvent-elles prédire les résultats d’élections ? Depuis quelques années, les data analysts et data scientists viennent bousculer le marché des sondages avec des démarches inspirées des méthodes de traitement des Big data et de l’intelligence artificielle.

Jusqu’à très récemment, seules les méthodes développées par les instituts de sondages permettaient de prédire des résultats électoraux, de manière relativement fiable. Celles-ci consistent à interroger un échantillon jugé suffisamment représentatif d’un électorat donné, puis d’extrapoler les réponses à l’ensemble de cet électorat. Avec leur multiplication depuis l’après-guerre, ces sondages se sont considérablement perfectionnés. Pourtant, ils sont confrontés à des critiques récurrentes et doivent aujourd’hui faire face à l’émergence d’une génération d’études qui se basent désormais sur les datas. Avec, d’une élection à l’autre, des succès divers… Retour sur les expériences les plus marquantes menées ces dernières années, avec ou sans contribution des sondages traditionnels :

Nate Silver, prodige des prédictions… Jusqu’à Trump

Le tournant, qui a inspiré bien des expériences et des vocations par la suite, est sans doute venu de Nate Silver, statisticien américain qui va démontrer le pouvoir des datas dans la prédiction électorale. Alors qu’il était principalement connu et reconnu pour ses analyses prédictives sur le baseball, il décide à partir de 2007, et sous pseudo, de publier des prévisions sur l’élection présidentielle américaine programmée l’année suivante. Il se dévoile finalement sous son vrai nom et crée le blog FiveThirtyEight.com pendant l’été 2008, savant mélange de sondages, de statistiques économiques de de datas historiques sur les élections outre-Atlantique. Ce modèle prédira correctement l’élection de Barack Obama et réussira à donner le vainqueur dans 49 des 50 Etats américains. Nate Silver prédira aussi avec exactitude les résultats des sénatoriales. En 2012, pour la réélection de Barack Obama, c’est même le carton plein : Nate Silver, qui a depuis vendu des milliers de livres et dont le blog est désormais hébergé par le New York Times, prédit le bon résultat dans les 50 Etats américains.

(Dave Kotinsky/Getty Images for the 2015 Tribeca Film Festival/AFP)

Le retour de bâton sera pour la présidentielle suivante. En 2016, Nate Silver et le New York Times annoncent une large victoire d’Hillary Clinton face à Donald Trump. La démocrate est créditée d’une probabilité de victoire de 71,4% par FiveThirtyEight.com. Mais la Floride, le Michigan, la Pennsylvanie et le Wisconsin basculent du côté du tempétueux milliardaire, ce que les modèles de Nate Silver n’avaient pas prévu. C’est un double camouflet pour le New York Times qui avait aussi combiné sondages et statistiques dans son projet “Chance of winning presidency“. Au meilleur de sa forme, cet indicateur donnait jusqu’à 85 % de chances de gagner à Hillary Clinton, contre 15 % pour Donald Trump…

Twitter, mine d’or ou leurre ?

Nate Silver et le New York Times ne seront pas les seuls à passer complètement à côté du phénomène Trump. Entre 2008 et 2016, un réseau social va voir le nombre de ses utilisateurs exploser et va, dans le même temps, devenir le terrain de jeu d’une nouvelle génération de chercheurs : Twitter. Des travaux universitaires vont fleurir au sujet de l’ “Opinion mining”, autrement dit l’analyse des opinions sur le réseau social, certains dans le domaine politique. Et ces travaux vont encore inspirer plus d’une expérience de prédiction.

Un autre statisticien basé à New York, Hernan Makse, va ainsi essayer lui aussi de prédire les résultats de l’élection de 2016, avec une méthode particulière : avec son équipe de recherche et son “Kcore Lab” ils ont décidé de décortiquer les données issues de 171 millions des tweets portant sur Hillary Clinton et Donald Trump et d’utiliser le machine learning pour le faire. Les résultats, détaillés a posteriori en avril 2017, ne seront pas vraiment concluants : le modèle annoncera Hillary Clinton gagnante avec 55,5 % des voix.

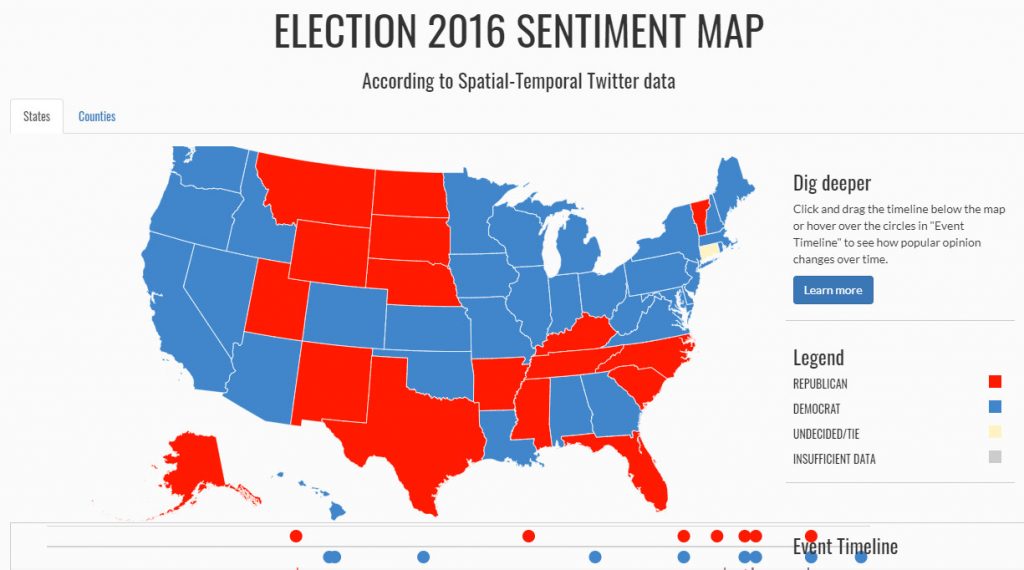

Parmi les projets menés sur Twitter à l’occasion des élections américaines de 2016 on peut aussi citer le site Estorm.org, monté par un groupe de chercheurs regroupés sous le patronyme InitialDLab. Ces chercheurs, rattachés à l’école d’informatique de l’Université de l’Utah, en partenariat avec la prestigieuse université de Tsinghua de Pékin, vont user des algorithmes d’analyse lexicale pour déterminer les sentiment positifs ou négatifs de plusieurs centaines de milliers de tweets. Leurs conclusions seront assez proches de la compilation de sondages du New York Times. Autrement dit, encore une fois, rien de très concluant.

Le summum revient probablement à l’entreprise canadienne Advanced Symbolics, une firme basée à Ottawa et spécialisée en intelligence artificielle. Son business de base : entrer dans la tête des consommateurs pour abreuver de datas ses clients (Disney, Bell et de grands complexes commerciaux au Canada et aux Etats-Unis). Sans doute soucieuse de montrer ses compétences au monde entier (et de se faire au passage un petit coup de pub), Advanced Symbolics jouera aussi au jeu des pronostics pour l’élection américaine de 2016. Son IA, baptisée “Polly”, sera alimentée en données extraites des médias sociaux et de billets de blogs suivant un échantillon représentatif de 200 000 Américains en âge de voter. Polly a également parcouru des milliers de sites d’information en ligne pour aider à déterminer dans quel sens le vent électoral soufflait. Et Erin Kelly, la CEO d’Advanced Symbolics, confiante dans son modèle, d’assurer qu’il était en mesure de “comprendre le sarcasme et d’autres nuances de la langue anglaise”. Le hic : Polly a prédit une victoire d’Hillary Clinton. “Les Américain sont-ils prêts pour une présidence Trump ? Notre IA dit que non”, osera même annoncer la PDG dans a presse. Perdu !

MogAI, seule vraie réussite de la présidentielle de 2016

Dans ce déferlement d’études pour la plupart erronées sur l’avènement de Donald Trump, une initiative est néanmoins parvenue à sortir son épingle du jeu. Et celle-ci est venue d’une start-up indienne, Genic.ai, emmenée par son emblématique patron Sanjiv Rai. Spécialisée en intelligence artificielle elle aussi, la petite société de ce “sérial entrepreneur” va développer un robot, répondant au doux nom de “MogAI”. Ce dernier va analyser le comportement des internautes et, à contre-pied des sondages, va constater que depuis 12 ans, les gagnants des présidentielles et des primaires sont toujours les candidats qui ont obtenu le plus fort taux d’engagement sur les réseaux sociaux. A ce petit jeu, Donald Trump surclasse ses concurrents, avec une stratégie extrêmement bien rodée.

En décortiquant environ 20 millions de conversations sur Facebook, Twitter et YouTube, MogAI va ainsi pronostiquer la victoire du milliardaire deux semaines avant le scrutin. Donald Trump aurait surpassé le niveau d’engagement atteint par Barack Obama lui même en 2008 sur les réseaux sociaux. Avec sa prédiction réussie, MogAI va notamment accréditer la thèse selon laquelle même les commentaires négatifs profitent au candidat, pourvu qu’il fasse parler de lui. Pour la petite histoire, le nom MogAI a été inspiré de Mowgli, jeune héros du “Livre de la jungle”, qui apprend de son environnement avec un réel sens de l’observation.

D’autres formes de datas explorées

En février 2017, un chercheur en sciences humaines et sociales à l’Université de Houston, au Texas du nom de Ryan Kennedy va de son côté réaliser une étude d’ampleur plutôt prometteuse. Dans la revue Science, en février 2017, lui et son équipe estiment que leur modèle prédictif mixant sondages, données économiques et éléments de contexte politique pour plus de 500 élections dans 86 pays différents entre 1945 à 2015 est concluant. Testé sur un peu moins de 130 élections récentes, il est parvenu à prédire avec justesse 80% des résultats. Un succès que David Lazer, co-auteur de l’étude, attribuera cependant à la prise en compte de sondages dans le modèle. Sans eux, la fiabilité du modèle aurait chuté à 65 % selon l’étude.

Une autre approche a été proposée en 2015 par Taha Yasseri, chargé de recherche en sciences sociales informatique à l’Oxford Internet Institute (Université d’Oxford). Ce physicien d’origine iranienne, connu pour ses recherches sur les “sciences sociales de calcul” va mener avec un autre chercheur, Jonathan Bright, une étude basée sur Wikipédia et sur les élections européennes. Ils vont comptabiliser le nombre de visiteurs quotidiens sur les pages Wikipédia des partis politiques en lice pour tenter d’établir des corrélations avec les résultats des européennes de 2009 et 2014. Cette fois, l’échec est total : la fréquentation de l’encyclopédie en ligne n’a en rien préfiguré ces résultats. Yasseri et Bright vont reconnaître que les électeurs qui se sont connectés aux pages des partis politiques voulaient en réalité se renseigner, a minima, sur les listes nouvelles ou insolites qui sont légion dans ce genre de scrutin.

Et en France ?

En France, le jeu des prédictions électorales à l’aide de datas et de machine learning n’est pas encore allé très loin. Deux sociétés, une start-up française et une entreprise canadienne, ont abondamment été citées lors de l’élection présidentielle de 2017, mais leur travail relevait plus d’une analyse de viralité que d’une réelle expérience de prédiction. La première, Vigiglobe, se présentait comme un outil d’analyse des échanges sur les réseaux sociaux. Son fait d’armes : avoir détecté une forte poussée du “Brexit” face au “Remain” sur les réseaux sociaux le soir du référendum au Royaume-Uni en 2016. Alors quand elle va souligner des “dynamiques favorables” à Benoît Hamon ou François Fillon, à quelques semaines de la présidentielle française, elle sera abondamment reprise dans la presse. Mais ces indices seront vite balayés par la décrépitude du Parti socialiste d’un côté et par une campagne plombée par les affaires de l’autre.

Filteris, une société canadienne créée en 2002 par un couple de Français expatriés, fera beaucoup plus de bruit. Plusieurs médias conservateurs, comme l’hebdomadaire Valeurs Actuelles ou le site Internet Le Salon Beige, vont mettre en lumière cette entreprise spécialisée en “web-réputation” qui, après avoir “prédit la victoire de Fillon à la primaire de la droite”, va le placer “devant Emmanuel Macron au 1er tour de la présidentielle”. Un raccourci en réalité puisque Filteris mesure quotidiennement une analyse des “opinions positives et négatives” sur les réseaux sociaux pour chaque candidat, à qui elle attribue alors un “score” qui n’a rien à voir avec des intentions de vote ou un quelconque pronostic… Dans les articles évoquant ses mesures, on ne manquera pourtant pas de rappeler que Filteris avait prédit la victoire de Donald Trump, alors qu’il s’agissait d’une simple analyse du bruit sur les réseaux sociaux encore une fois. En pleine affaire Fillon, les chiffres de Filteris auront pourtant été repris par les supporters du candidat LR soucieux de démontrer que leur champion était toujours dans la course. Bruno Retailleau, coordinateur de la campagne Fillon, utilisera lui aussi ces chiffres sur Radio Classique, avant le premier tour : “Nous avons des sondages qui sont faits avec ce que l’on appelle le big data et qui placent François Fillon en numéro deux, malgré l’énorme matraquage qu’il y a eu depuis des semaines. Donc tout est ouvert”. On connaît la suite.

Deux prédictions, deux échecs

Deux “vraies” expériences de prédictions seront néanmoins menées lors de la présidentielle française de 2017. La première par Leonie Hill Capital, société d’investissement basée à Singapour. En se basant sur une intelligence artificielle mixant des données extraites des réseaux sociaux, des sondages, ainsi que de statistiques démographiques et économiques, celle-ci va, dès le mois de février 2017, annoncer que Marine Le Pen affronterait Emmanuel Macron au second tour de la présidentielle en mai de la même année. L’IA ira même jusqu’à prédire que c’est la candidate du FN qui remporterait l’élection. Leonie Hill Capital va notamment baser son analyse sur un “effet Donald Trump” et sur un prétendu “coup d’accélérateur” offert par la qualification au second tour de la candidate d’extrême droite.

La seconde expérience de prédictions a été portée par cinq étudiants de l’école Télécom Paris Tech, rassemblés derrière un projet au nom prometteur : “Predict My President”. Relayée dans l’hebdomadaire Le Point, leur analyse croise elle aussi le big data et les sondages à l’époque, avec quelques subtilités. Mohamed Al Ani, Davy Bensoussan, Alexandre Brehelin, Bertrand de Véricourt et Raphaël Vignes intégreront par exemple à leur modélisation mathématique des recherches Google, des résultats électoraux et des sondages d’opinion depuis 1981, mais aussi des statistiques de l’Insee et de Data.gouv, les seules, disent-ils déjà, en mesure de servir d’indicateurs à l’échelon local. Les cinq étudiants formuleront d’ailleurs leur problématique d’une manière assez proche de notre propre expérience aujourd’hui : “par quelles variables sont dictés les votes temporels et territoriaux ?” Et leur méthode, elle aussi, en rappelle une autre : “des modèles de Machine Learning et d’économétrie permettant de déterminer un taux de vote” pour une série de “blocs” politiques prédéterminés.

Les limites du modèle ne seront pas éludées. Les données des réseaux sociaux “ne représentent qu’une catégorie de la population”, les données socio-éco-démographiques souffrent d’une “discontinuité” qui peut “influer sur la marge d’erreur”, les données de recherche Google risquent de faire remonter des “épiphénomènes”, indiquaient les data-scientists. Et ils avaient raison de se méfier : à cinq jour du premier tour de l’élection, leur modèle donnera Marine Le Pen en tête avec un score de 24,13 %, devant François Fillon à 21,77 % et Emmanuel Macron, troisième, à 20,32 %. Autrement dit le bon trio de tête, mais dans un ordre inexact.

Voir les sources et références des travaux mentionnés dans cet article